Apple 宣布将制定一项新协议:自动扫描 iPhone 和 iPad,以检查用户照片中是否存在儿童性侵犯材料 (CSAM)。该公司这样做是为了限制 CSAM 的传播,但也增加了其他功能,“以保护儿童免受使用通信工具招募和剥削他们的掠夺者的侵害,”苹果在一篇博客文章中解释说。目前,这些功能仅在美国可用。

Apple 将在 iOS 15 和 iPadOS 15(预计将在未来几个月内推出)中建立一项新功能,该功能将自动扫描用户设备上的图像,以查看它们是否与先前识别的 CSAM 内容匹配,该内容由唯一的哈希值识别(例如,重复图像之间一致的一组数字,如数字指纹)。

检查哈希值是网站安全公司 CloudFare于 2019 年设立并由反儿童性交易非营利组织 Thorn使用的检测 CSAM 的常用方法,该组织由 Ashton Kutcher 和 Demi More 共同创立。

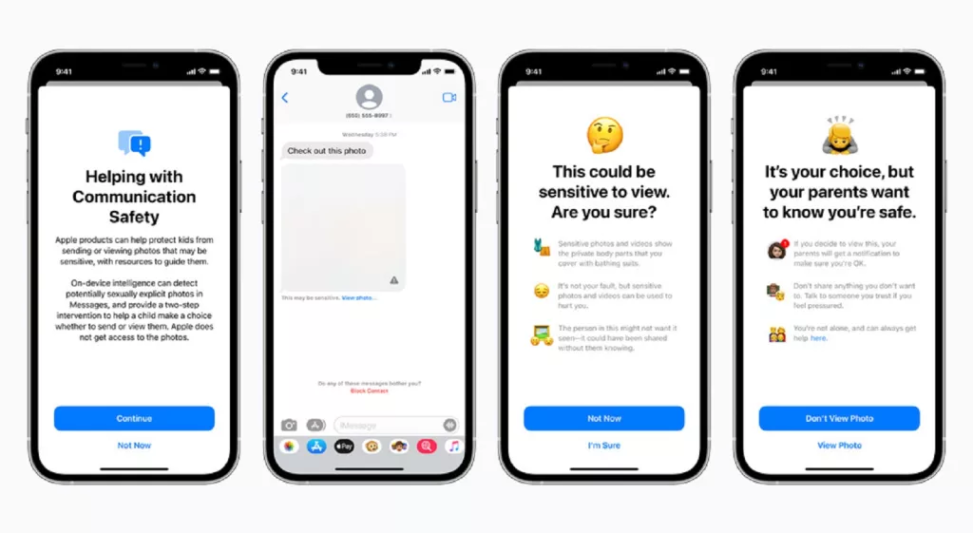

此外,Apple 还添加了两个系统,父母可以选择为他们家庭网络中的孩子启用:首先,消息应用程序中的设备上分析,扫描传入和传出的照片,寻找可能具有色情内容的材料,默认情况下会被模糊化,如果内容被查看,可选设置可以通知帐户关联的父母。

如果用户询问报告 CSAM,Apple 还允许 Siri 和搜索显示有用的资源;当用户搜索与 CSAM 相关的查询时,两者都会进行干预,告知搜索者该材料的潜在危害,并指向寻求帮助的资源。

这概述了 Apple 自己的描述,它将如何集成软件来跟踪 CSAM,并通过在儿童接收(和发送)可能不适当的照片时进行干预来帮助保护他们免受掠食。但 Apple 自动扫描您的材料的前景已经引起了技术专家和隐私权倡导者的关注——我们将在下面深入探讨。

这会影响我吗?

如果您的 iPhone 或 iPad 上没有带有 CSAM 的照片,那么您不会有任何改变。

如果您不进行与 CSAM 相关的 Siri 查询或在线搜索,您将不会有任何改变。

如果您的 iPhone 或 iPad 帐户是在 iCloud 中为家人设置的,并且您的设备在该网络中被指定为儿童,则您会在收到色情照片时看到警告和模糊的照片。如果您的设备未链接到属于孩子的家庭网络,则您不会有任何改变。

最后,如果您不升级到 iOS 15、iPadOS 15 或 macOS Monterey,您的设备将不会获得任何这些功能。(后者可能会扫描 iCloud 照片以获取 CSAM,但尚不清楚当 macOS Monterey 用户使用该应用程序时,是否也会发生对色情照片的消息干预。)

这些更新仅面向美国用户,目前尚不清楚何时(或是否)将它们扩展到其他地方——但鉴于 Apple 将这些定位为保护措施,如果他们不将其扩展到用户,我们会感到惊讶在其他国家。

苹果为什么要这样做?

从道德的角度来看,Apple 只是通过遏制 CSAM 来授权父母保护他们的孩子并提供社会服务。正如该公司在其博客文章中所述,“该计划雄心勃勃,保护儿童是一项重要责任。”

Apple 一再支持其设备的隐私功能,并通过诸如最大化设备分析(而不是将数据上传到云中的公司服务器)和安全的端到端加密通信等措施以及诸如在 iOS 14.5 中首次亮相的App Tracking Transparency。

但多年来,苹果公司也一直在接受大量诉讼,这些诉讼似乎促使该公司加强隐私保护——例如,欧盟的一名消费者权益倡导者于 2020 年 11 月起诉这家科技巨头,理由是苹果公司分配每个根据《卫报》,iPhone 是广告商标识符 (IDFA),用于跨应用程序跟踪用户。这可能促使 Apple 通过 App Tracking Transparency 为消费者提供更多控制权,或者至少与公司正在进行的行动保持一致。

科技雷达找不到会迫使 Apple 进行这些更改的特定诉讼,但该公司完全有可能通过为年轻用户提供更多自我保护工具以及在其自己的 iCloud 服务器和 iPhone 上消除 CSAM 来主动保护自己总的来说——所有这些都可以想象在未来限制苹果的责任。

但是,如果您可以移除 CSAM 材料,为什么不呢?

安全研究人员怎么看?

在 Apple 推出新举措后不久,安全专家和隐私倡导者发出了警告——当然,不是为使用 CSAM 辩护,而是出于对 Apple 在用户设备上检测 CSAM 的方法的担忧。

因为 CSAM 扫描功能似乎不是可选的——它几乎肯定会默认包含在 iOS 15 中,并且一旦下载,就与操作系统密不可分。从那里,它会在用户将照片上传到 iCloud 帐户之前自动扫描他们设备上的照片——如果在扫描过程中一定数量的照片与这些 CSAM 哈希匹配,Apple 会手动检查被标记的图像,如果他们确定它是有效的 CSAM,用户的帐户将被关闭,他们的信息将传递给与执法部门合作的国家失踪和受虐儿童中心 (NCMEC)。

除非违反与已知 CSAM 的相似性阈值,否则 Apple 非常谨慎地对用户数据进行加密且公司员工无法读取。根据 Apple 的说法,“阈值设置为提供极高水平的准确性,并确保每年错误标记给定帐户的几率低于万亿分之一。”

但它是自动扫描让隐私倡导者拥护。“后门就是后门,”数字隐私非营利组织电子前沿基金会(EFF) 在其博客文章中写道,回应苹果的倡议,理由是即使添加这种自动扫描技术也为可能更广泛的访问滥用打开了大门:

“扩大 Apple 正在构建的狭窄后门所需要的只是扩展机器学习参数以寻找其他类型的内容,或者调整要扫描的配置标志,不仅仅是儿童的,而是任何人的账户。那不是滑坡;这是一个完全构建的系统,只是在等待外部压力做出最细微的改变,”EFF 写道,并指出其他国家通过的法律要求平台扫描用户内容,例如印度最近的 2021 年规则。

科技行业的其他人也同样反对苹果的自动扫描计划,包括 Facebook 旗下的 WhatsApp 消息服务负责人 Will Cathcart。在 Twitter 帖子中,他指出了 WhatsApp 让用户更容易标记 CSAM 的做法,他声称这导致该服务去年向 NCMEC 报告了超过 400,000 个案例,“所有这些都没有破坏加密。”

公平地说,Facebook 一直试图绕过Apple 的 App Tracking Transparency:在被迫披露其移动应用程序(和 WhatsApp 的应用程序)访问多少用户数据后,Facebook 尝试提示用户允许访问,同时批评 Apple 的 App Tracking Transparency对依赖该广告收入的小企业(可能还有 Facebook)造成伤害。

其他技术专家在完全支持 EFF 的观点之前,正在等待 Apple 提供更多信息。

科技研究和分析公司Techsponential 的创始人 Avi Greengart通过 Twitter 消息告诉 TechRadar:“EFF 和其他隐私倡导者对专制政权滥用的担忧可能是令人震惊的或反应过度——苹果需要提供更多的实施细节。” . “但是,作为父母,我确实喜欢 iMessage 会在发送前标记未成年人色情短信的想法;任何能暂时减缓进程并让孩子有机会思考后果的事情都是好事。”

发表回复